728x90

728x90

Mixture models

전체 모집단 내 하위 모집단의 존재를 나타내는 확률론적 모델. 즉 여러 개의 분포가 혼합되어 있는 모델이다.

GMM(Gaussian Mixture models)

가우시안 혼합 모델은 여러 개의 가우시안 분포가 혼합된 clustring 알고리즘이다. 현실에 존재하는 복잡한 분포들을 k개의 가우시안 분포를 혼합하여 표현을 한다.

EM for Gaussian mixture

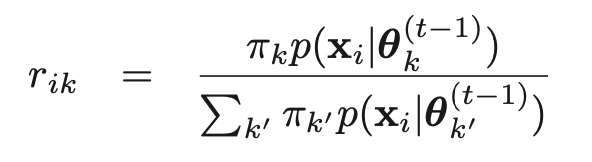

주어진 데이터 Xn에 대하여 데이터가 어떠한 가우시안 분포가 생성되는지 찾기 위해 responsibility r(ik)를 다음과 같이 정의하였다. Xn에 따른 GMM의 k번째 가우시안 분포가 선택되면 1, 아니면 0의 값을 갖는다. r(ik)가 1이라는 것은 Xn이 k번째 가우시안 분포에서 생성되었다는 것을 의미한다.

가우시안 혼합 분포(GMM)를 통해 Xn이 주어졌을 때, k개의 r을 계산하여 가장 높은 가우시안 분포를 선택한다.

E-step

M-step

<EM - example>

728x90

728x90

'AI > Machine Learning' 카테고리의 다른 글

| [머신러닝]베이지안 네트워크(Bayesian Network)- 컴도리돌이 (3) | 2020.12.17 |

|---|---|

| [머신 러닝] Agglomerative(bottom-up) , top-down(divisive) - 컴도리돌이 (0) | 2020.10.30 |

| [머신 러닝] EM(Expectation-Maximization) vs MLE(Maximum likelihood estimation) soft clustering , k-means clustering - 컴도리돌이 (0) | 2020.10.22 |

| [머신 러닝] performance evaluation(precision,recall) - 컴도리돌이 (1) | 2020.10.22 |

| [머신 러닝] Overfiting - 컴도리돌이 (0) | 2020.10.21 |